温馨提示

- 推荐阅读

- 换一换

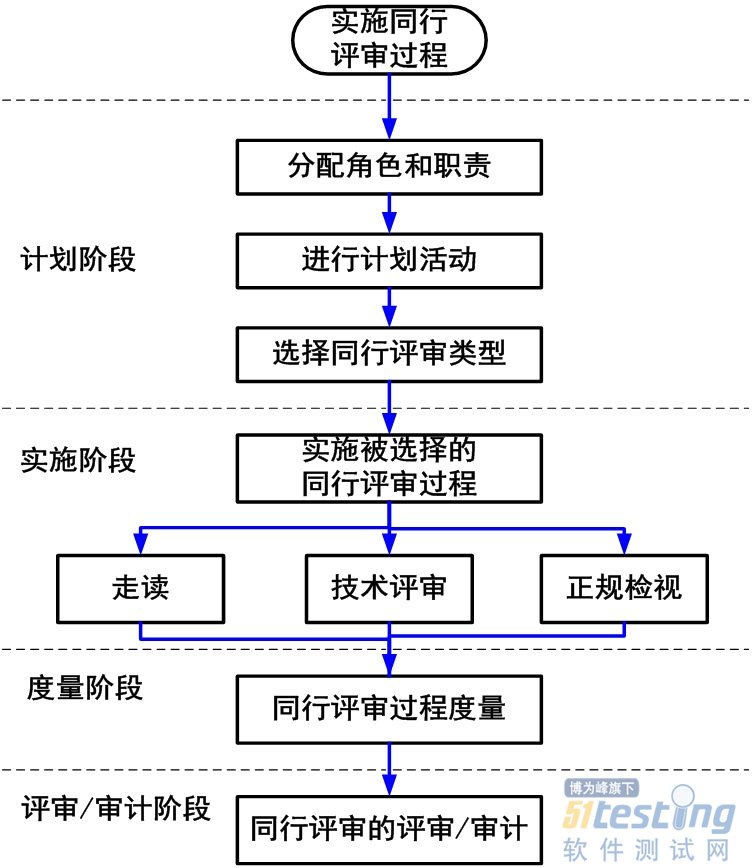

- 软件测试同行评审到底是什么?——软件测试圈06-12“同行评审是一种通过作者的同行(开发、测试、QA等)来确认缺陷和需要变更区域的检查方法。”在软件测试中,同行评审是用来检验软件开发,软件评测各阶段的工作是否齐全,规范,各阶段产品是否达到了规定的技术要求和质量要求,以决定是否可以转入下一阶段的工作。软件评审是为了确保软件开发项目的顺利进行而必须进行的工作,往往同行评审时由5人以上的团体来完成的,在一定的时间内,发现尽量多的错误,是评判一个同行评审是否达到要求的评价指标。 在同行评审中,部门评审阶段一般分为九个阶段: 1.系统分析和设计 2.软件需求分析 3.系统概要设计 4.软件详细设计 5.代码和单元测试 6.软件组件测试 ...

- 测试工程师的职场发展二三谈——软件测试圈03-09前言 今天几个测试圈子的大佬约了饭局,席间彼此交流了很多关于职场工作上测试相关的话题,听了他们的一些观点很有启发,我自己对于聊的话题也做了一些描述和实际的案例说明。下面是聊的一些关键话题,我将交流的内容和个人观点整理了下,供大家参考。 从测试leader的角度如何保障质量交付? 聊的第一个话题就是测试leader如何保障团队的质量交付,这个话题最近在很多地方,听很多人聊过。我会尝试从以下几点来做阐述说明,观点仅代表个人看法。 流程管理 问:流程是什么?为什么要有流程?流程能解决什么问题?流程能带来什么保障? 流程是什么? 流程是保障团队目标达成的最佳实践,因人/团队/业务类型...

- 深入浅出自动化测试框架设计与搭建09-03相信有很多小伙伴了解学习过自动化测试,也研究过现在比较火的selenium自动化脚本编写,更有很多同学能够独立设计出一个完整的自动化脚本,并且成功执行了;还有一些更喜欢研究的同学能够通过Jenkins持续集成的方式将自己的自动化测试代码在服务器上运行起来。到这里,可能有些同学会说,我已经学会了自动化测试。真的是这样么? 我们可以一起回忆一下:我们为什么要做自动化?答案自然是为了提升工作效率。大家回想一下,我们写出的自动化脚本给我们带来的效率上的收益是不是已经大于了我...

- OpenAI 表示,它希望采纳公众关于如何确保其未来人工智能模型"符合人类价值观"的意见。为此,这家人工智能初创公司今天宣布,正在组建一个由研究人员和工程师组成的新的"集体对齐"(Collective Alignment)团队,以创建一个系统,收集公众对其模型行为的意见,并将其"编码"到 OpenAI 的产品和服务中。 "我们将继续与外部顾问和资助团队合作,包括开展试点,将......原型纳入我们的模型指导中,"OpenAI 在一篇博文中写道。"我们正在招募......来自不同技术背景的研究工程师,...

-

- 【测试流程】新一轮的测试制度梳理来了10-17印象中,测试流程制度这块,我们每年都会更新,当然啦,还是hr追的紧啊,主要目的说是为了保障线上质量。浅浅分享一下吧,觉得实用可以直接抱走。今年我们主要抓的部分分为两个,一个是计划达成率,一个是线上质量。按照实际完成的情况进行加分或者扣分。一、【计划达成率】按照测试计划及测试用例进行测试,符合相关项目规范,100%完成开发计划。因个人原因,每延迟一天,扣10分,项目整体提前一天及以上,加10分。(项目具体日期按照项目评估时间进行)二、【上线后质量】产品/功能上线后的经分析是测试遗漏导致的bug,进行扣分。若是P1级别的bug,1个扣10分,若是P2级别bug,1个扣5分,若是P3级别bug,扣1...

温馨提示

打开微信 扫一扫

温馨提示

设置支付密码

- 关于我们 联系我们 版权声明 广告服务 站长统计

- 建议使用IE 11.0以上浏览器,800×600以上分辨率,法律顾问:上海兰迪律师事务所 项棋律师

- 版权所有 上海博为峰软件技术股份有限公司 Copyright©51testing.com 2003-2024, 沪ICP备05003035号

- 投诉及意见反馈:webmaster@51testing.com; 业务联系:service@51testing.com021-64471599-8017

- 51testing软件测试圈微信