- OpenAI宣布成立团队 在模型中加入"众包"治理理念——软件测试圈

OpenAI 表示,它希望采纳公众关于如何确保其未来人工智能模型"符合人类价值观"的意见。为此,这家人工智能初创公司今天宣布,正在组建一个由研究人员和工程师组成的新的"集体对齐"(Collective Alignment)团队,以创建一个系统,收集公众对其模型行为的意见,并将其"编码"到 OpenAI 的产品和服务中。

"我们将继续与外部顾问和资助团队合作,包括开展试点,将......原型纳入我们的模型指导中,"OpenAI 在一篇博文中写道。"我们正在招募......来自不同技术背景的研究工程师,帮助我们一起开展这项工作。"

Collective Alignment团队是OpenAI去年5月推出的一项公共计划的产物,该计划旨在为建立"民主程序"以决定人工智能系统应遵循哪些规则的实验提供资助。OpenAI 在首次推出该计划时表示,该计划的目标是资助个人、团队和组织开发概念验证,以回答有关人工智能的防护和治理问题。

在今天的博文中,OpenAI 回顾了获得资助者的工作,其中包括视频聊天界面、人工智能模型众包审计平台以及"将信念映射到可用于微调模型行为的维度的方法"。今天上午,受资助者工作中使用的所有代码都被公开,同时还公布了每项提案的简要摘要和高层次的收获。

OpenAI 试图将该计划与其商业利益剥离开来。但考虑到OpenAI首席执行官山姆-阿尔特曼(Sam Altman)对欧盟和其他地区监管的批评,这有点难以接受。阿尔特曼与OpenAI总裁格雷格-布罗克曼(Greg Brockman)和首席科学家伊利亚-苏茨基弗(Ilya Sutskever)曾多次争辩说,人工智能的创新速度太快了,我们不能指望现有机构能够充分控制这项技术,因此需要众包这项工作。

包括 Meta 在内的一些 OpenAI 竞争对手指责 OpenAI(包括其他公司)试图通过游说反对开放式人工智能研发来确保"对人工智能行业的监管",OpenAI 对此予以否认,并很可能将拨款项目(以及 Collective Alignment 团队)作为其"开放性"的例证。

无论如何,OpenAI 正受到来自政策制定者越来越多的审查,在英国,它正面临着一项有关其与亲密合作伙伴和投资者微软公司关系的调查。这家初创公司最近试图降低其在欧盟的数据隐私监管风险,利用一家位于都柏林的子公司来削弱欧盟某些隐私监管机构单方面采取行动的能力。

毫无疑问,部分原因是为了打消监管机构的疑虑,OpenAI 昨天宣布,它正在与一些组织合作,试图限制其技术被用于通过恶意手段左右或影响选举的方式。这家初创公司所做的努力包括:让使用其工具生成的人工智能图像更加清晰可见,以及开发即使在图像被修改后仍能识别生成内容的方法。

作者:cnBeta

原文链接:今日头条(toutiao.com)

- -1.00 查看剩余0%

- 【留下美好印记】赞赏支持

- 推荐阅读

- 换一换

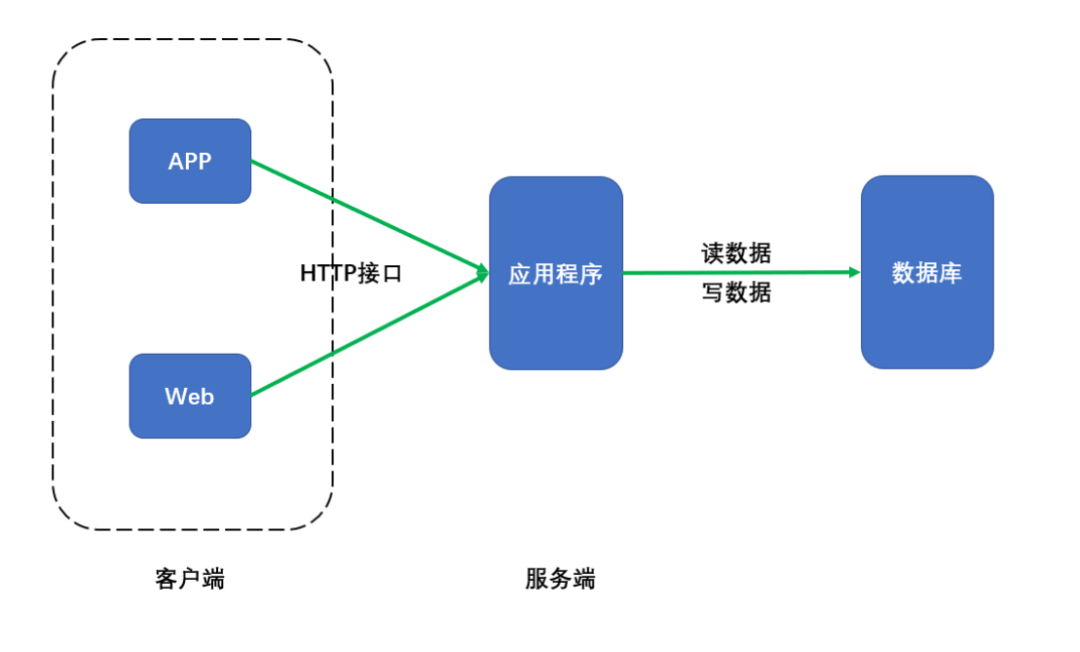

- 接口测试到底怎么做?——软件测试圈04-2901 通用的项目架构02 什么是接口接口:服务端程序对外提供的一种统一的访问方式,通常采用HTTP协议,通过不同的url,不同的请求类型(GET、POST),不同的参数,来执行不同的业务逻辑。客户端大多数的业务操作,都是需要调用服务端接口来获取一些数据,或者触发某些业务,然后客户端拿到接口返回的数据后,会根据数据内容做不同的处理和展示。03 为什么要做接口测试A、在公司里,客户端和服务端通常是由不同的团队开发的,在项目开发过程中,客户端和服务端开发的进度不一致,比如服务端先开发完了,这个时候可以先对服务端进行接口测试,确保服务端逻辑和返 回数据是正确的,然后再测试...

- Dify 一词源自 Define + Modify,意指定义并持续改进你的 AI 应用。随着大型语言模型(LLM)不断涌现的各种能力,AI 应用的场景变得更加广阔。然而,对于大多数开发者而言,基于 GPT 等大型语言模型、Langchain 等技术框架开发 AI 应用仍然是一项门槛极高的任务。开发者必须花费大量时间学习各种晦涩的概念和技术研究,也无法进行 AI 应用的持续运营。是否有这样一个工具,开发者无需关注基础设施的底层原理,只需专注于将想象力转化为实际落地的 AI 应用并持续运营,可以将大型语言模型变成像云计算服务一样易于使用?基于这个问题,Dify.AI 诞生了。它是为你而做的(Do ...

-

- 张忠谋是半导体行业的传奇人物。这位美籍台湾商人和电气工程师于 1987 年创立了台积电,被誉为台湾整个半导体行业之父,时至今日,他仍在大胆预测未来。张忠谋最近表示,目前对人工智能硬件加速器的需求如此之高,以至于他的公司很快就要以惊人的速度倍增产能。 张忠谋是在台积电在日本熊本建立的位于该国第一家制造工厂的落成典礼上作出上述表示的,他期待着这个亚洲国家出现新的"芯片复兴"。 这位台积电创始人说,他与未具名的人工智能芯片公司代表进行了交谈,这些高管人物向这家台湾代工厂提出了一些前所未有的要求。张忠谋说:"他们说的不是数以万计的晶圆,而是希望台积电建立新的制造工...

-

- 支付宝分层与端到端回归平台建设实践09-11一、方案特色: 1.一体化:统一技术体系、统一管控模式、统一调度模式、统一用户体验,有效的提升了平台本身的可维护性,极大的提升了平台的用户体验和使用成本; 2.分层回归:支持分层自动化(单元测试、接口测试、WebUI自动化、前端测试)和端到端(全链路WebUI自动化)持续回归; 3.集成性:提供丰富的API,便于与其他平台(如研发协作平台等)的集成; 4.原子性:方案的运作具备独立的使用周期,不依赖于其他平台或系统; 5.扩展性:自主研发,可快速进行方案扩展,如代码质量度量体系、覆盖率、持续集成等; 6.业务解耦:自动化管控模块AQC-Auto与手动用例管控模块AQC-Case...

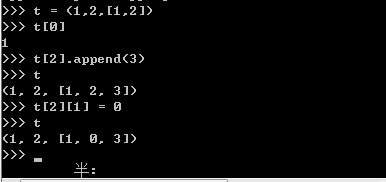

- Python中几种常见的列表——软件测试圈10-18Python是一门非常简洁的语言,和c/c++,java等有着较大的差别。到list和tuple这儿有点犯迷糊了,就从这儿开始写起。目前做接触到的列表有4个,dicth和set,这篇文章就来看看这几种列表的特性和用法。一、python“数组”ListList是python内置的一种数据类型列表。在我看来有点类似于数组,但是深究下来却有很多不同。题外话:python和以往学过的编程语言最大的不同在于变量不用声明类型,也就是可以实现如下操作:a = 3 print(a) a = ‘s’ print(a)这样的操作在大多数在以前学过的三种语言种都是不合法的,但...

- 关于我们 联系我们 版权声明 广告服务 站长统计

- 建议使用IE 11.0以上浏览器,800×600以上分辨率,法律顾问:上海兰迪律师事务所 项棋律师

- 版权所有 上海博为峰软件技术股份有限公司 Copyright©51testing.com 2003-2024, 沪ICP备05003035号

- 投诉及意见反馈:webmaster@51testing.com; 业务联系:service@51testing.com021-64471599-8017

- 51testing软件测试圈微信