- 在 Dify 轻松调用顶尖开源与国产模型,解锁不同模型的潜力

Dify 的朋友们,

不少细心的网友在周末的时候就已经发现了我们产品上的更新 -- 模型供应商上新增了一大批新模型,这也是很多朋友翘首以盼的版本-- V0.3.13。

此前 Dify 已经陆续支持了全球前列的模型优秀代表:OpenAI 的 GPT 系列、Anthropic 的 Claude 系列、Azure OpenAI 系列。本次更新,让大家可以轻易使用上国内外知名的开源模型如:Llama2、ChatGLM、百川Baichuan、通义千问-7B 等,凡托管在 Hugging Face 及 Replicate 上的模型,在 Dify 上只需要输入 Hugging Face 、 Replicate 的 API token 和模型名称就可以轻松接入调用。同时,我们与国内数家模型厂商达成了友好的上下游合作,讯飞星火、MiniMax、文心一言、通义千问都已在本批次接入。(我们还为 Dify 的朋友们争取到部分模型厂商的 token 体验额度,申请通道详见下文。)

轻松调用 Llama2 、ChatGLM 、Baichuan 等开源模型

Dify 支持模型托管和部署平台 Replicate 和 Hugging Face 上所有的模型, Llama2、ChatGLM、百川 Baichuan、通义千问-7B 等你都可以轻松调用,快速构建性能优异且多样化的 AI 应用。

以部署托管在 Replicate 上的 Llama2 为例,来看看如何在 Dify 上调用开源模型吧!

建立安全、合规可控的模型阵地

国内用户更关注的是模型的合规可控性,无疑国内闭源商用模型是最优选择。Dify 已接通国内闭源商用模型如文心一言、讯飞星火、MiniMax、通义千问,这些模型在安全性和价值观上更符合国情,满足合规审查和企业对可控性的需求。

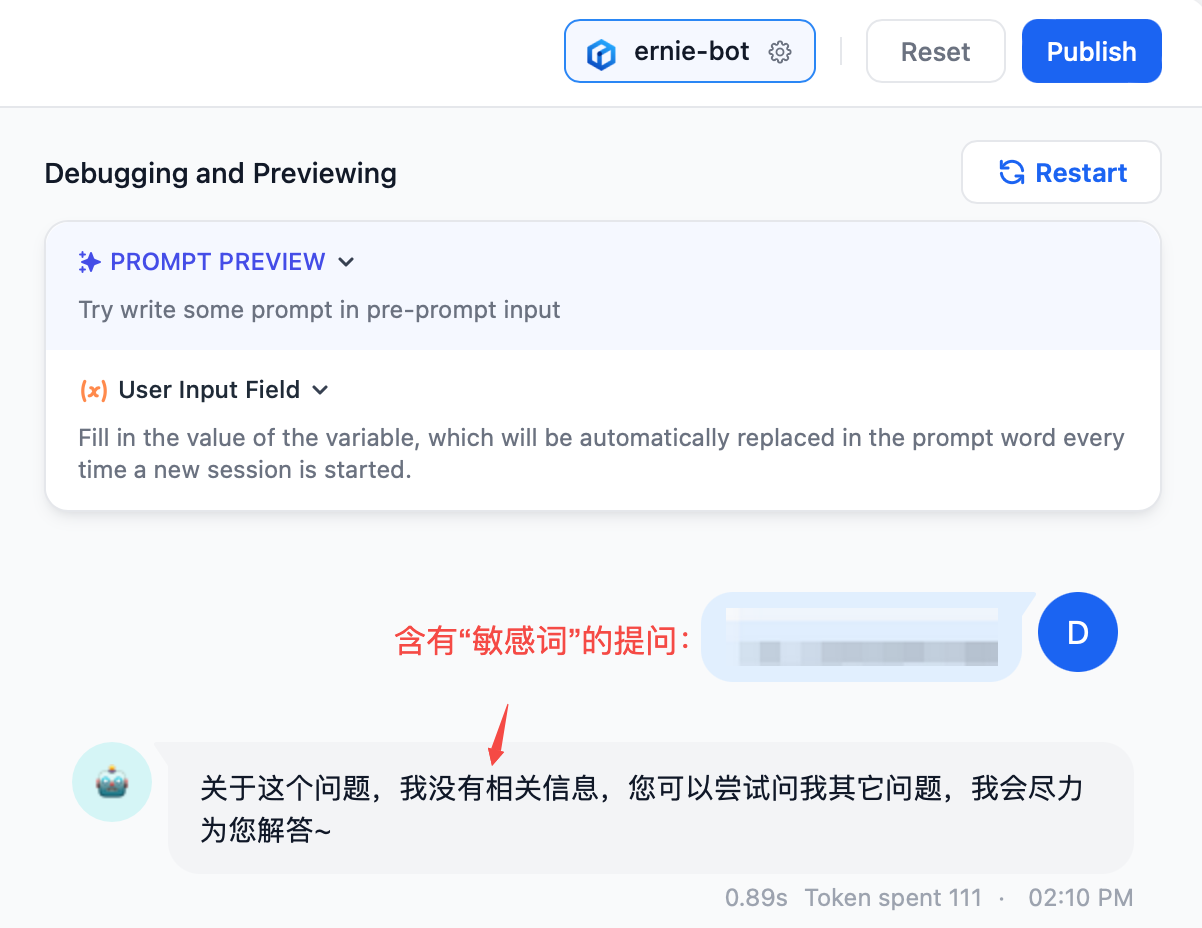

以百度文心一言为例,用户在 Dify 用该模型创建应用时,关于“敏感词”的合规性问题会得到很好的处理:

但由于目前国内模型暂无法开放大规模商用,所以我们与其中部分模型厂商深度沟通合作,给 Dify 用户争取到讯飞星火、MiniMax 分别 300 万、100 万的 token 体验额度,建议提前探索评测,选定适合自己业务的模型,大规模开放后即可在 Dify 上创建安全合规的 AI 应用。

如何申请体验额度?通过 Dify 设置 --> 模型供应商 --> 讯飞星火或 MiniMax 图标处点击【免费获取】:

讯飞星火:免费领取 300 万 token,需要从 Dify 的入口进入,完成讯飞星火开放平台的注册,返回 Dify 静候 5 分钟即可在 Dify 页面体现可用额度(仅限未注册过讯飞星火的手机号)。

MiniMax:免费领取 100 万 token,只需点击【免费领取】即可到账额度,无需手动注册流程。

在 Dify.AI 探索不同模型潜力

快速切换,测验不同模型的表现。基于 Dify 上集成的 LLMs,你可以在应用制作的页面下快速切换不同模型,仅需几分钟就可以迅速评估在特定场景下各个模型的具体表现,这可以帮助你基于测试结果做出更明智的模型选择,获取最佳体验。

降低模型能力对比和选择的成本。过去,当你需要探索不同模型的能力边界,你需要逐个去研究不同模型的性能、不断调整不同模型的不同参数等,投入大量时间和精力。而现在基于 Dify,你只需要在应用的模型选择器中点击切换即可实现不同模型能力的反馈和对比。另外,Dify 已对各模型进行了预调优,设定最佳系统 Prompt,简化复杂的参数设置。你无需学习各模型的使用细节,直接在 Dify 上选择并得出最优模型方案。这极大降低了模型选择和调优的门槛,让你能更加高效地构建 LLM 应用。

选择使用哪个大型语言模型?

今年以来,层出不穷的模型和迭代速度让人眼花缭乱,可谓是“百模齐放盛世”。在模型的选择上,部署成本、训练成本、推理性能、模型能力表现等方面都起着至关重要的影响。下面小编根据各大专业机构评测/官方披露信息总结几个热门开源/闭源模型的优势和能力适用情景特点供大家参考:

百花齐放的开源模型

Llama2: 众所周知,Meta 出品的 Llama 是开源模型的“鼻祖”,在其模型能力表现上甚至超过了 GPT-3,但遗憾的是不能商用。但前不久 Meta 又发布的 Llama 2 系列,不仅允许了商业化使用,任何企业、个人开发者都能将其用在商业用途,且在网络规模、训练数据量和模型架构上都有显著提升,相比之前的 Llama 1,Llama 2 在预训练数据量上增加了 40%,达到了 2 万亿个语言单元。同时,输入文本长度也扩大一倍,到达 4096 个词元。这使得 Llama 2 更适合处理长序列语言建模任务。

ChatGLM:清华技术成果转化的公司智谱 AI 推出了 GLM 系列的中英双语对话模型 ChatGLM-6B,拥有 62 亿参数,支持消费级显卡上的推理。该模型在 1T 的中英双语标识符训练基础上,通过多种技术进行优化,虽然由于模型容量较小,模型记忆和语言能力较弱,但胜在降低了部署门槛、提升了效率。ChatGLM2-6B 是部署在 hugging face 上的第二代版本,在保留了初代模型对话流畅、部署门槛较低等众多优秀特性的基础之上,ChatGLM2-6B 通过升级模型、扩展上下文、优化推理和开放协议,实现了性能、效率与兼容性的全面提升。

百川 baichuan:百川大模型是由百川智能公司自主研发的大语言模型,其中 7B 和 13B 提供开源版。Baichuan-7B 是在大约 1.2 万亿 tokens 上训练的 70 亿参数模型,而 Baichuan-13B 采用更大规模参数与训练数据,同时开源预训练与对齐版本,推理更高效,且开源免费可商用。据官方透露,百川即将在下个月上线闭源商用模型 53B 版本,提供在线体验平台和 API,官网已提供了内测入口。

通义千问-7B:阿里云在 8 月 3 日开源了 7B 参数模型:通义千问-7B(Qwen-7B),这是阿里云研发的通义千问大模型系列的 70 亿参数规模的模型,在 hugging face 上一跃成为热度仅次于 Llama2 的文本生成型模型。Qwen-7B 是基于 Transformer 的大语言模型,在超大规模的预训练数据上进行训练得到。预训练数据类型多样,覆盖广泛,包括大量网络文本、专业书籍、代码等。丰富的预训练资源为 Qwen-7B 模型提供了坚实的知识基础,使得 Qwen-7B 在各类任务上的适应性非常强,无论是对话、文本生成还是问答,都能取得较好的效果。

专业评测验证国产模型实力

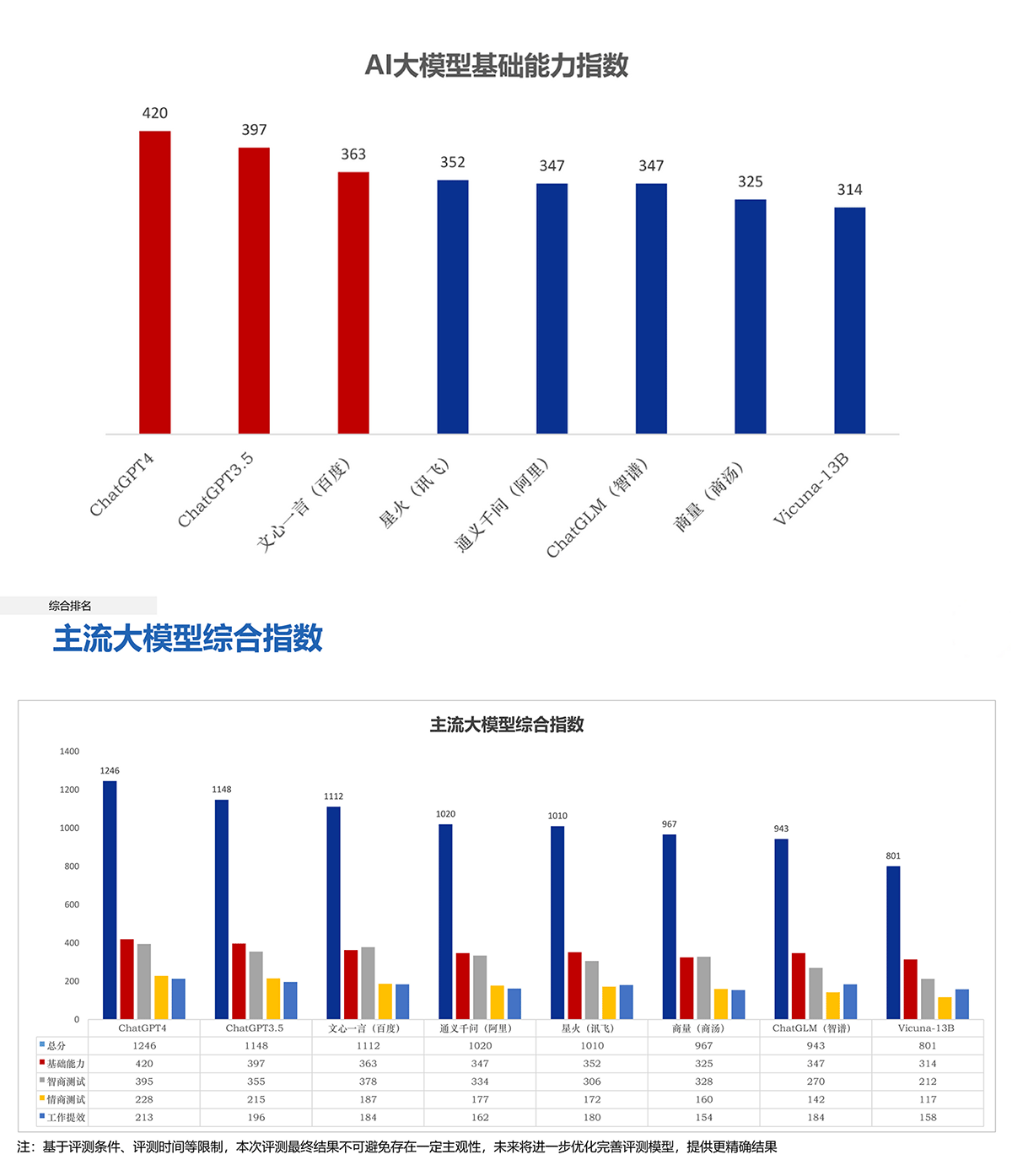

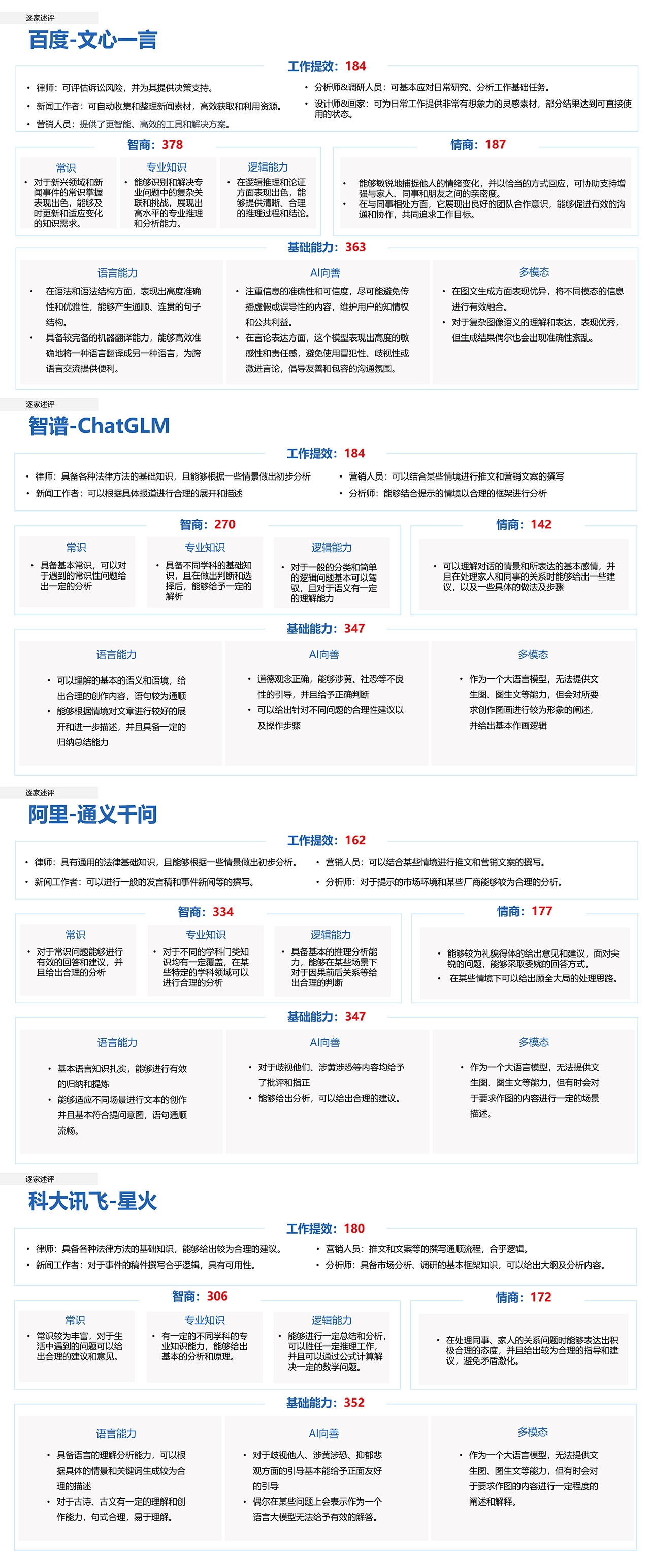

对于国产模型,我们查阅了新华社研究院对主流大模型发布的《人工智能大模型体验报告》。测试采用模块化设题的方法设计客观题和主观题,从模型回答的可用性、语义准确度、逻辑清晰度、创新性等方面与 ChatGPT4、ChatGPT3.5 进行对比打分:

整体上国产大模型相较于 ChatGPT ,在基础能力、智商测试、情商测试、工作提效上都有不俗的表现。再来看看更具体的分析:

总的来看,各模型展现出不同的特长:

文心一言在语言理解和生成能力方面表现突出,对文本语义的处理达到较高水平;

通义千问在知识图谱构建和常识问题处理上优势明显,知识系统较为全面;

讯飞星火的语言表达和语义组织能力较强,生成的语句通顺流畅;

ChatGLM 模型在完成智能助理等实际工作的效果较好,可胜任各类智能问答和写作任务。

当然,不同评测机构的评测角度稍有不同,具体落地使用更重要的是结合业务情景本身来选择,在 Dify 上你可以基于你的业务数据来测试不同模型的表现,选择最适合你业务的模型供应商。

除了以上模型支持,在本次版本中我们也新增了 OpenAI 的自定义 API 域名能力,支持任何兼容 OpenAI 的大模型 API 服务器。Dify 后续还将陆续支持如 google PaLM、百川商用版 53B、本地微调模型等的适配接入,敬请期待。

其他更多的小特性和 bug 修复请参考 release 信息:https://github.com/langgenius/dify/releases/

如果你喜欢 Dify,欢迎:

在 GitHub 上贡献代码,与我们一同共建更好的 Dify;

通过线上线下活动、社交媒体向你的朋友们分享 Dify,以及你的使用经验;

在 GitHub 上给我们点亮⭐️

- -1.00 查看剩余0%

- 【留下美好印记】赞赏支持

- 推荐阅读

- 换一换

- 问题描述: 有些系统接口判断用户是否登录,是校验登录接口成功后传的token值,也就是请求系统所有接口时,前端传参必带登录成功后接口返回的token,后台以此检验是否过期或是否有登录。所有接口都依赖登录成功后的token,那么可将token进行关联。本案例实现请求登录接口,获取token,将token关联至另外的get请求或post请求实现步骤:import json import requests import urllib.parse import urllib.request def doLogin(): &nbs...

-

- 之前进行接口测试一直用印度的postman,后来发现一款国产神器ApiPost,完全可以秒杀postman这个印度货。必须安利一波! 1、可以便捷的生成格式规范的文档 记得以前当程序员的时候,每次写接口,基本都是自己大概一写,然后api地址和大致参数发群里就完事儿,剩下全靠前端猜,实在猜不出来了就喊两声:xx,那个yy参数是啥意思? ApiPost的出现,解决了这个问题:很便捷的生成接口文档。而且更重要的是,这款软件生成的接口文档基本非常规范,并且支持多种格式。如下图: 这就是ApiPost越来越受欢迎的原因之一:可以便捷的生成格式规范的文档。 2、方便规范化开发文档的管理 后...

-

- 大厂裁员潮下,测试人员路在何方?09-15首发:https://mp.weixin.qq.com/s/h_7n1EAPD_UyRkN3L4wxIQ同类文章推荐:https://mp.weixin.qq.com/s/nh4c9El9FjJtX4vy8m2ELA 世纪性难题:剪不断、理还乱的开发测试关系大基建时代,人们怀揣着“三总五项”的梦蜂拥入土木建筑的行列,不知是否有人想到他们中的大部分归宿是“提桶跑路”。时代的浪潮一波接着一波奔腾而来,有高潮就有低谷,有兴盛必有衰亡,烈火烹油时代的我们不提前着手准备,浪潮褪去后,裸泳将会是一件尴尬局促的事情。01行业与个人经济发展遵循着一条客观规律,复苏》繁荣》衰退》萧条。它不因个人、组织...

- 据报道,美国加州一家法庭裁决称,在一宗安卓操作系统反垄断诉讼过程中,科技巨头Alphabet旗下的谷歌(101.9,0.54,0.53%)公司故意毁灭员工的内部聊天证据,谷歌将为此遭到罚款,并且在后续审判过程中面临进一步惩罚。 美国加州洛杉矶的一家联邦地方法庭法官JamesDonato在裁决书中表示,在保存案件有关证据方面,谷歌没有履行自己的责任。 据报道,这宗复杂的反垄断诉讼涉及到多个司法管辖区,其中包括了一个有关2100万名美国人的消费者集体诉讼,覆盖了美国38个州和哥伦比亚特区,涉及到的公司包括游戏厂商Epic以及相亲约会服务商Match集团。 这一反垄断诉讼的关键点,是消费者...

-

- 面试如何正确谈薪?——软件测试圈03-26金三银四马上来了,又是一波离职高峰,很多小伙伴已经开始投身跳槽的准备中了。大家选择跳槽无非是想增加自己的工资收入,所以面试过程中的谈薪环节就显得尤为重要,谈的好与不好,未来整个的薪资水平都可能受影响。那面试中,当问到“你的期望薪资是多少?“应该如何回答呢?作为一名软件测试资深面试官,站在求职者角度,从以下3个方面聊一聊:了解市场薪资行情清楚薪酬结构面试如何谈薪1、了解市场薪资水平案例: 小柠,工作2年,上家薪资是8000,跳槽后9500,跟身边朋友和前同事相比,个人很满意。 结果入职后发现,比自己晚入职技能也不如自己的新同事,薪资却过万,顿时心里不舒服了。一般来说,跳槽涨薪可达10%-30%,...

- 关于我们 联系我们 版权声明 广告服务 站长统计

- 建议使用IE 11.0以上浏览器,800×600以上分辨率,法律顾问:上海兰迪律师事务所 项棋律师

- 版权所有 上海博为峰软件技术股份有限公司 Copyright©51testing.com 2003-2024, 沪ICP备05003035号

- 投诉及意见反馈:webmaster@51testing.com; 业务联系:service@51testing.com021-64471599-8017

- 51testing软件测试圈微信